Willkommen zum Teil 2!

Artikel von Gerhard Kulzer (Übersetzung hauptsächlich von Oliver Dörr).

Dieser Text behandelt viele Aspekte der Pflege digitaler Inhalte, insbesondere von Bildern und digitalen Kopien. Aber vieles in diesem Artikel ist gleichermassen anwendbar auf andere digitale Inhalte wie Musik, Dokumente, künstlerische Werke aller Art.

Schützen Sie Ihre Bibliothek vor Datenverlusten

Themen: Plattenfehler, Plattenausfall, Stromstöße, ECC, Übertragungsfehler, Alterung der Speichermedien, Wiederherstellung, Redundanz, Desastervorbeugung, Lebenszeit, Temperatur, Datengröße, Verbreitete Aberglauben

Was sind die Hauptgründe für den Verlust von digitalen Daten?

Natürlich reden wir hier nicht über CDs die auf der Straße oder einem Brand verloren gingen. Diese Art von Verlusten sind dieselben die Ihnen auch bei traditionellen Papierfotos oder Negativen passieren können. In diesem Abschnitt geht es um Probleme bei den so genannten "Neuen Medien".

Probleme mit digitalen Daten können grob in die folgenden Bereiche gegliedert werden:

die physikalische Alterung des Mediums. Alle Medium altern, wenn auch in unterschiedlichen Zeitspannen.

unbemerkte Übertragungsfehler während eines Datentransfers.

die mangelnde Unterstützung für proprietäre digitale Formate über einen längeren Zeitraum.

veraltete Hardware.

Kroll Ontrack, die größte Datenwiederherstellungsfirma der Welt, hat einige interessante Statistiken welche Gründe ein Datenverlust hat.

Gründe für Datenverlust | Wahrnehmung | Realität |

| Hardware oder Systemproblem | 78% | 56% |

| Menschlicher Irrtum | 11% | 26% |

| Softwarefehler oder -problem | 7% | 9% |

| Computer-Viren | 2% | 4% |

| Katastrophe | 1-2% | 1-2% |

Lassen Sie uns diese Gründe Schritt für Schritt analysieren!

Physikalische Alterung

CD, DVD, Optische Laufwerke

Physikalische Alterung der Medien passiert viel schneller mit Papier und CD-Rs als bei Filmen. Obwohl Filme länger halten, manchmal sogar um Dekaden länger, als andere Medienformen, wird bei der richtigen Art des Backups niemals etwas verloren. Filme verfallen - digitale Einsen und Nullen nicht. Ein Film fängt in dem Moment an dem er erstellt und entwickelt wurde an zu verfallen. Er wird niemals die gleiche Farbe, Kontrast usw. haben wie er einen Augenblick vorher hatte. Digitale Daten machen dies nicht, sind aber anfällig für Korruption! Zusätzlich sind physische Medien wie Disketten und magnetische Laufwerke ebenfalls anfällig für den Verfall des Mediums. Er braucht nur länger.

Um das Problem bei CDs/DVDs zu bekämpfen müssen diese vorsichtige behandelt werden und man darf Ihnen nicht länger als ein paar Jahre trauen. Natürlich können Sie auch CDs und DVDs in Archivqualität kaufen welche länger halten, schwieriger zu bekommen und wesentlich teurer sind. Es gibt Angebote über Gold beschichtete DVDs, $2 das Stück die eine Lebenszeit von 100 Jahre für sich beanspruchen. Ob Sie das glauben liegt in Ihrem Ermessenspielraum.

CD/DVD Disks können unlesbar werden, aber Sie können dieses Risiko reduzieren in dem Sie gute Disks und gute Aufnahmegeräte benutzen und sie auf die richtige Art und Weise lagern. Die besten DVD Aufnahmegeräte sind nicht wesentlich teurere als die billigsten, aber Sie schreiben viel verlässlicher. Es dreht sich also darum den richtigen auszuwählen.

CDs und DVDs sind sehr anfällig für Fehler, selbst wenn Sie gerade erst geschrieben wurden. Darum benutzen sie einen Kontrollsummenmechanismus um sich zu schützen. 75% der Daten sind nur effektive Daten, der Rest wir benötigt für die Formatierung und die Kontrollsummen. Trotz dieses massiven Schutzes altern sie durch chemische Alterung, Ultraviolettes Licht, Kratzer, Staub usw.

Für defekte CDs und DVDs gibt es ein günstiges Programm namens IsoBuster das anscheinend Wunder bei CDs und DVDs bewirkt. Es läuft unter Windows und Linux, ist aber noch nicht für Macs verfügbar. Es gibt auch ähnliche Anwendungen die beschädigte Daten von beschädigten Disketten, Festplatten, Flashmedien, USB-Laufwerken usw. auslesen.

Optische Medien: Blu-ray Disks scheinen den Formatkrieg gegen die "HD DVD" zu gewinnen. Eine Dual-layer Blu-ray Disk kann 50 GB speichern und somit fast sechsmal die Kapazität einer Dual-layer DVD mit 8,5 GB. Alles was zu CDs und DVDs gesagt wurde gilt natürlich auch für die Blu-ray Disk.

Bewährtes Verfahren:

Brennen Sie langsam mit einem guten Aufnahmegerät auf qualitativ hochwertigen Medien in einem nicht proprietären Format. Lesen Sie danach die Daten wieder aus , um Sie zu überprüfen. Ebenfalls Sollten Sie die Medien mit einer Beschreibung, Datum & Autor kennzeichnen und danach an einem sauberen, dunklen trockenen und vor Tieren geschützten Ort lagern. Vergessen Sie nicht die Daten auf die nächste Generation von Medien zu kopieren bevor Sie das letzte Stück Hardware bzw. Software das diese Medien lesen kann ausrangieren.

Festplatten (Laufwerke, HDD)

Diskhersteller behalten Ihre Statistiken für sich. Ihre Herstellergarantien umfassen eine neue Disk, aber nicht die Daten. Google stellt zu diesem Thema eine große Feldstudie über die Fehlermechanismen von Festplatten zur Verfügung: Hardisk Fehlerstudie

In Kürze: Disks halten am längsten, wenn Sie im Temperaturbereich von 35°C bis 45°C betrieben werden (HDD-Temperatur). Bei niedrigeren Temperaturen erhöht sich die Fehlerrate dramatisch. Elektronische Teile des Controllers sind die häufigste Fehlerursache, SMART kann diese Fehler nicht feststellen. Aber einige von SMART festgestellten Fehler kündigen den unmittelbar bevorstehenden Ausfall an, insbesondere Lesefehler und Verlagerungsfehler. Die erwartete Lebenszeit beträgt zwischen 4 und 5 Jahren.

Die Lebensdauer hängt allerdings von der wirklichen Benutzung und einem bisschen Glück ab. So habe ich z.B. ein Fujitsu Notebook dass seit 1998 im 24/7 Betrieb ohne die geringsten Probleme läuft. Nur Glück? Im Allgemeinen, und damit im Gegenteil zum allgemeinen Glauben und ökonomischen Betrachtungen, hält eine Festplatte, die permanent an ist, länger als eine, die dauernd an und ab geschaltet wird. Es wurde sogar schon berichtet, dass aggressives Energiesparen und Verlangsamen der Platte diese schnell beschädigt. Dass eine Platte viel arbeitet, verringert natürlich Ihre Laufzeit, aber die schlimmsten Faktoren für eine Festplatte sind Vibrationen, Schocks und kalte Temperaturen.

Wenn Ihre Platte komische Geräusche macht, dann kommen Sie mit normaler Datenrettungssoftware normalerweise nicht weit. Wenn dies passiert, sollten Sie noch ein schnelle Sicherung, wenn möglich mit dem dd-Befehl machen. Eine normale Datei-basierte Sicherung ist nicht geeignet, da dd in einem gleichmäßigen spiralförmigen Strom vom Anfang bis zum Ende alles ausliest und dadurch die Mechanik nicht so stresst. Es gibt Firmen die sich auf die Datenrettung spezialisiert haben und auch Daten von zerstörten Platten wieder herstellen können. Dies ist aber teuer, und Sie sollten mit mindestens 2000$ rechnen.

Stromstöße

Ungefähr 1% aller Rechner bekommen jedes Jahr einen Blitzeinschlag oder einen Stromstoß ab.

Hierbei handelt es sich nur um die Komplettverluste aufgrund von Überspannung. Natürlich können Sie auch Datenverlust aufgrund eines Stromausfalls bevor Sie die Dateien gesichert haben, aber diese Verluste lassen sich normalerweise ohne große Probleme wieder herstellen.

Sie müssen nicht auf das nächste Unwetter warten, um sich darüber Gedanken zu machen was eine plötzliche Stromspannung für Ihren Rechner bedeutet. Aktuelle Statistiken zeigen das 63 Prozent aller Elektronikverluste auf Energieprobleme zurück zu führen sind und das die meisten Rechner zwei oder mehr Stromanomalien pro Tag erleben. Da Stromstöße und -ausfälle überall und zu jederzeit passieren können macht es Sinn Ihren Rechner durch entsprechende Hardware davor zu schützen.

Wie Stromstöße passieren

Ein Stromstoß tritt auf, wenn die Spannung auf der Leitung länger als 10 Millisekunden über die Standardwerte erhöht ist. Sechzig Prozent aller Stromstöße werden Zuhause oder im Büro durch ein Gerät mit einem Motor, dass an- oder ausgeschaltet wird, verursacht. Solche Geräte können Haartrockner, Kühlschränke oder Wasserpumpen sein. Diese Geräte verursachen dann einen kurzen Spitzenverbrauch in der Spannung. Die übrigen 40 Prozent entstehen aus Ursachen wie Blitzeinschläge, Netzwerkumschaltungen, Leitungsschläge, schlechte Kabel und so weiter.

Während den meisten elektrischen Geräten Stromstöße nicht viel ausmachen sieht das bei Geräten mit Computerchips und Hochgeschwindigkeitsprozessoren anders aus. Diese können schweren Schaden nehmen. An Ihrem Rechner können diese Anomalien gesperrte Tastaturen, kompletten Datenverlust, Hardwarealterung, zerstörte Motherboards und andere Defekte verursachen. schützen Sie also sich selbst vor dem Unvermeidbaren das zu einem Verlust von Zeit und Geld führt.

Überspannungsschutz

Der am meisten verbreitete Schutz gegen Stromspitzen ist ein Überspannungsschutz. Dies ist ein Gerät, das ein Teil der Energiespitze absorbiert und den Rest erdet. Es ist normalerweise in Form einer Steckerleiste erhältlich. Denken Sie aber daran, dass nicht jede Steckerleiste auch einen Überspannungsschutz enthält.

Wenn Sie sich einen Überspannungsschutz aussuchen, dann sollten Sie darauf achten, dass er den UL 1449 Standard erfüllt. Dieser garantiert ein bestimmtes Minimum an Schutz. Sie sollten ebenfalls darauf achten, dass er Schutz gegen Blitzeinschlag bietet und eine Versicherung für die angeschlossenen Geräte.

Da eine Überspannung jedes Kabel zu Ihrem Rechner benutzen kann, sollten Sie darauf achten, dass auch alle Peripheriegeräte, die an Ihrem System angeschlossen sind geschützt sind. Dies gilt auch für Telefonleitungen und Kabelmodems, da auch durch diese eine Überspannung erreichen kann. Einige Herstellern stellen Überspannungsschutzgeräte her die auch einen Telefonanschluss für Ihr Modem enthalten. Andere bieten Anschlussmöglichkeiten für das Koaxialkabel des Kabelmodems und der Fernsehkarte.

Wenn Sie über ein Notebook verfügen, dann werden Sie einen tragbaren Überspannungsschutz benötigen. Eine Vielzahl dieser Geräte sind speziell für Notebooks gestaltet und daher sehr klein, und Sie enthalten auch den Schutz für das Modem, ideal für unterwegs.

Unterbrechungsfreie Stromversorgung (USV)

Während ein Überspannungsschutz Ihr System vor kleineren Schwankungen in den Stromleitungen beschützt, wird es Ihnen bei einem Komplettausfall nicht wirklich helfen. Selbst ein Ausfall von wenigen Sekunden kann zum Verlust von unersetzlichen Daten führen. Es kann daher sinnvoll sein, in eine unterbrechungsfreie Stromversorgung zu investieren.

Neben dem Schutz vor Überspannungen können diese Geräte automatisch Akku-Energie zur Verfügung stellen, wenn ein Stromausfall eintritt. Dies gibt Ihnen die Möglichkeit, Ihre Daten zu speichern und das System geordnet herunterzufahren. Einige Modelle erlauben es ihnen sogar, weiter zuarbeiten bis der Strom wieder läuft. Wenn Sie eine USV kaufen, dann sollten Sie sich sicher sein, dass sie dieselben Qualitätsanforderungen wie ein Überspannungsschutz erfüllt. Darüber hinaus ist die Lebenszeit der Batterie und die beiliegende Software interessant.

Betrachten Sie das potentielle Risiko, dem Ihr Rechnersystem ausgesetzt ist und vergleichen Sie seine Sicherheit bei Stromstörungen mit den Kosten zur Vermeidung derselben. Ein qualitativ hochwertiger Überspannungsschutz wird Sie etwa €20 kosten. Eine 500W USV können Sie für weniger als €40 bekommen. Dies ist nur ein kleiner Preisunterschied, wenn Sie bedenken wie gut Ihr Rechner damit beschützt ist. Zum Schluss sollten Sie daran denken, immer alle Kabel zu trennen bevor Sie in die Ferien fahren.

Harddisks, USB-Sticks, Speicherkarten, Flashspeicher

Harddisks sind mechanisch robuster als normale Festplatten und Sie werden nicht so stark beansprucht wenn Sie in einen Rechner gesteckt werden. Allerdings sind sie als meist mobile Geräte ist bei ihnen das Risiko viel höher, dass Sie hinfallen, Unfälle haben oder elektrostatisch entladen werden. Daher können sie aus unterschiedlichen Gründen so häufig ausfallen wie normale Festplatten. Wenn Sie nun die Gefahr des Diebstahls, die geringere Lebensdauer und die beschränke Kapazität betrachte, dann eigenen sich Harddisks nur sehr eingeschränkt als permanente Datenspeichergeräte.

Einer der Hauptgründe für Datenverlust ist die ungesicherte Entfernung dieser Harddisks von einem Rechner. Bevor Daten aus dem Hauptspeicher des Rechners auf ein angeschlossenes Gerät gespeichert werden, werden Sie häufig in einem Puffer kurz zwischen gespeichert. Für Festplatten sind dies meistens nur Sekunden. Bei Festkörperlaufwerken dagegen können es bis zu zehn Minuten werden. Daher sollten Sie bevor Sie ein Flash-Gerät von Ihrem Rechner entfernen immer darauf achten, dass Sie die Daten wirklich auf das gerät schreiben. Dies geht häufig durch ein Menüpunkt Namens "Gerät sicher entfernen".

Es gibt den neuen Trend die alten Festplatten durch Harddisks zu ersetzen. Ungefähr 2010 sollen sie in den gleichen Preisregionen wie Festplatte liegen. Der Datenerhalt ist allerdings etwas, dass bei Harddisks beachtet werden muss. Sie können nicht unendlich oft überschreiben werden, sondern nutzen sich bei der Benutzung ab. Der Grad der Abnutzung hängt davon ab wo und wie oft die Daten geschrieben werden. Unter Linux wird ein spezieller Treiber benutzt der versucht zu verhindern, dass auf denselben Punkt zu häufig geschrieben wird. Dies sind aber alles vorzeitige Informationen. Halten Sie also Ihre Augen und Ohren offen.

Magnetische Medien

Magentische Bänder werden in Sicherungssystemen benutzt und sind häufiger in professionellen Umgebungen als in Privaten zu finden. Bänder sind anfällig für Datenstau und Technologieänderungen. Sie sind aber in einem Aspekt sicherer als CDs und DVDs: Sie leiden seltener unter Kratzer, Dreck und Schreibmängeln. Auf der anderen Seite reagieren Sie empfindlich auf magnetische Felder. Ein einzelner Magnet kann ein Band zerstören. Bänder sollten alle 5-8 Jahre um-kopiert werden damit nicht so viele Bits verloren gehen, dass die Prüfsumme den Inhalt nicht mehr rekonstruieren kann. Nachteile von magnetischen Bändern ist der Preis des Aufnahmegeräts und die Zurückspielzeit die 20 mal länger ist, als die von der Festplatte. Die besten Zeiten der Bandsicherungssysteme sind vorbei.

Logische Fehler

Web-Speicherdienste

Der Amazon Web-Dienst enthält S3 - Simple Storage Service - einen einfachen Speicherdienst. Mit der richtigen Konfiguration können Sie diesen als Laufwerk unter Linux, Mac, und Windows einbinden. Dies erlaubt es Ihnen, S3 als Backupziel für Ihre Software zu benutzen. Google Shared Storage ist ein weiteres beliebtes Angebot, mit dem Sie beliebigen Mengen an Daten speichern können.

Sie sind im Vergleich zu den Festplatten zu Hause allerdings sehr teuer - 100 GB kosten $150 pro Jahr und 1TB kosten $1500 (Stand 01/2012). Darüber hinaus müssen Sie die Daten über das vergleichsweise langsame Internet senden.

Die Lösungen eignen sich daher nur als Lösung gegen einen lokalen Datenverlust der wichtigsten Bilder. Es handelt sich hierbei nicht um eine schlechte Lösung, aber es ist keine allgemeine Sicherungslösung. Dafür ist es zu langsam.

Picasaweb (Google), Flickr (Yahoo) und Foto-Community 23hq.com bieten ebenfalls Onlinespeicher an. Der freie Speicherplatz ist dort auf 1 GB beschränkt und Sie werden dort nicht die Bilder in der vollen Auflösung speichern wollen. Flickr has a super offer to make right now: unlimited space costs less than 25$; a year. And 23hq seems to have a similar offer.

Update vom Sept. 2008: Wenn Sie hier oder hier schauen, finden Sie überragende Angebote für €4 und weniger pro Monat: unlimitierten Speicherplatz. Sie müssen nur ein Webhosting mieten und können per ftp Ihre Daten ins Web schaufeln. Allerdings bietet diese Sparpreisvariante keinen Komfort an, alles muss von Hand kopiert werden.

Hier ist eine weitere Liste von Online Diensten: Carbonite, Backblaze, Spider Oak, Mozy, SugarSync, Elephant Drive, Livedrive, SOS, MiMedia,ZumoDrive, Usenet Backup,Symantec Online Backup, Files Anywhere, Crashplan, Barracuda Backup Service, Acronis, ASUS Web Storage and Dolly Drive. Und hier ist werden sie verglichen.

Aus Sicht der Datensicherung sind die Web-Lösungen sehr sicher. Übertragungsfehler werden dank dem TCP-Protokoll automatisch bereinigt und bei den großen Firmen ist in dem Angebot eine Sicherung und ein verteilter Speicher enthalten. Damit sind sie Desastersicher.

Übertragungsfehler

Daten gehen nicht nur im Speichergerät verloren. Sie können auch innerhalb des Rechners oder über Netzwerke verloren gehen. Auch wenn TCP selbst einen Fehlerschutz hat. Fehler treten in Bussen und im Hauptspeicher auf. Die Hardware für Endverbraucher verfügt über keinen Schutz gegen diese Bitfehler, aber es kann es Wert sein danach zu schauen. Sie können teuren Speicher mit ECC-Schutz (Error Code Correction) kaufen. Mit diesem Speicher ist zumindest der Speicher gegen einzelne Bitfehler geschützt. Doppelte Bitfehler würden zwar nicht entdeckt, aber diese treten auch nur sehr selten auf.

Illustration 1: Datenübertragungskette im Desktop Computer.

Das Diagramm veranschaulicht die Elemente der Übertragungskette im Rechner. Alle Übertragungen sind anfällig für Übertragungsfehler. Die Dateisystem zfs und btrfs stellen zumindest die Datenintegrität zwischen Betriebssystem und Festplatte sicher.

Die Byte-Fehlerrate (BER) für den Speicher und Übertragungskanäle liegt in der Größenordnung von 10 hoch -7 Bit. Dies bedeutet, dass 1 von 3000 Bildern enthält einen Fehler nur wegen Übertragungsproblemen. Dies kann unter Umständen sehr dramatische Auswirkungen für ein Bild haben. Es kann zerstört sein oder es hat sich nur die Farbe eines einzelnen Pixel sich geändert. Da nahezu alle Bilder komprimiert sind, kann die Auswirkung eines einzelnen Bitfehler nicht vorher gesagt werden. Häufig betrachtet man nur eine Teil des Bildes anstatt dem kompletten Bild.

Das Schlimmste daran ist, dass Ihnen niemand sagt, wenn und wann ein Übertragungsfehler aufgetreten ist, nicht wenn dies in Ihrer Hardware geschah. All diese Störungen bleiben unentdeckt bis Sie eines Tages ein Foto öffnen und dies zur Ihrer Überraschung zerstört ist. Es ist ziemlich beunruhigend, dass es in Ihrem Rechner keinen Schutz dafür geben sollte. Niemand scheint je daran gedacht zu haben. Das Internet mit seinem TCP-Protokoll ist ein wesentlich sicherer Datenweg als der in Ihrem Rechner.

Unzuverlässige Netzteile sind eine weitere Quelle für Übertragungsverluste, da sie Interferenzen innerhalb der Datenströme erzeugen. Bei normalen Dateisystemen bleiben diese Fehler unbemerkt.

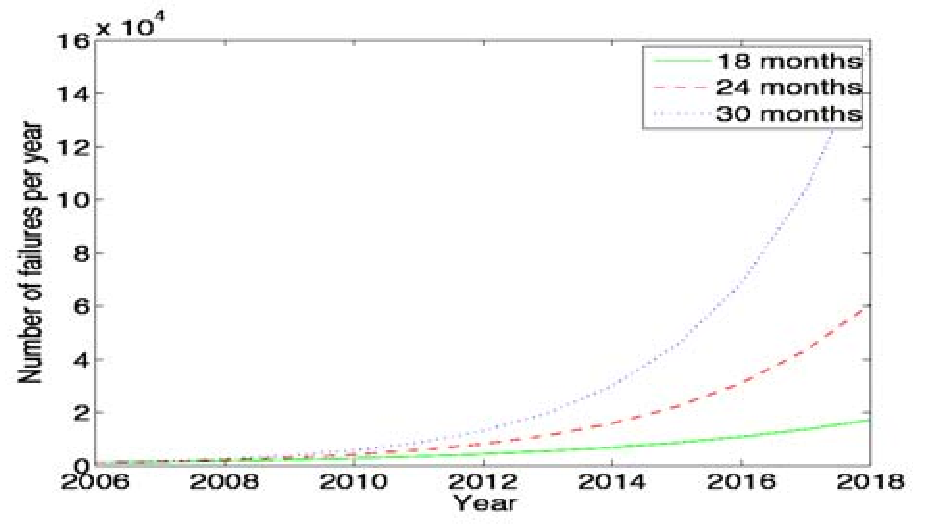

Die erwartete Fehlerrate wächst mit der Komplexität.

Selbst wenn Sie zurzeit nicht besonders von Übertragungsproblemen betroffen sind, sollten Sie in die Zukunft schauen. Schon 2010 werden Sie tausende Fehler pro Jahr sehen.

Wird es am Horizont der Dateisysteme ein 'Oracle' oder 'Sun' geben?

ZFS von Sun Microsystems scheint einer von zwei Kandidaten zu sein, die mit Plattenfehlern auf niedriger Ebene umgehen können und hochskalierbar sind. Es ist OpenSource, mit vielen Patenten und ist unter einer zur GPL inkompatiblen Lizenz für Solaris und Leopard erhältlich. Wir können nur hoffen, dass es bald auch für Linux und Windows verfügbar ist. Lesen Sie dazu diesen Artikel auf englisch.

Dies ist für die Mutigen unter Ihnen: Fuse ZFS

Oracle hat eine eigene Initiative mit seinem btrfs Dateisystem gestartet. Dies ist immer noch im Alpha-Status. Es benutzt dieselben Schutzmechanismen die zfs benutzt und ist auch für Linux erhältlich. Es ist aber noch nicht Teil des Kernels.

Menschliche Irrtümer

Diebstahl und Unfälle

Unterschätzen Sie dies nicht! Diese beiden Faktoren sind für 86% der Datenverluste bei den Notebook und 46% bei den Arbeitsplatzsystemen verantwortlich. Bei Notebooks beträgt schon der Anteil der Diebstähle 50%.

Schadsoftware

Schadsoftware

Datenverlust aufgrund von Viren ist weniger verbreitet als die Meisten denken. Es führt zu einem geringeren Schaden, als z.B. Diebstähle oder Neuinstallationen. Und es ist auf zur Zeit auf Microsoft-Systeme beschränkt Apple-Benutzer kennen nur sehr wenige Viren und unter Linux wurde schon lange keiner mehr gesichtet.

Panik ist ein Faktor für Datenverlust

Menschliche Fehler sind, wie so häufig, ein Hauptproblem beim Datenverlust. Atmen Sie tief durch und machen Sie eine Pause! Panik ist eine normale Reaktion und Leute machen wirklich dumme Sachen. Erfahrene Anwender ziehen die falsche Platte aus einem RAID-Array oder formatieren eine Platte und zerstören alle Ihre Informationen. Etwas zu machen ohne darüber nach zu denken ist sehr gefährlich für Ihre Daten. Stressen Sie sich also selbst nicht bei einem Verlust und machen Sie nichts mit Ihrer Platte. Arbeiten Sie am besten nicht weiter mit Ihrem Rechner bevor Sie einen Plan haben. Erklären Sie Ihren Plan einem Laien oder noch besser einer Laiin. Sie werden überrascht sein, wieviele dumme Ideen Sie bei dieser Übung entdecken.

Wenn Ihre Platte eigenartige Geräusche macht, dann wird eine normale Datenrettungssoftware nicht gut funktionieren. Machen Sie in diesem Fall eine schnelle Sicherung. Wenn sich die Platte noch dreht und Sie Ihre Daten nicht finden können, dann sollten Sie ein Datenrettungsprogramm suchen und auf einen anderen Rechner oder eine andere Platte sichern. Nicht-Linux Benutzer sollten nach "free data recovery software" suchen, um eine Auswahl zu haben. Hier finden Sie z.B. auch ein Programm von Ontrack. Es ist wichtig, dass Sie dieses Programm auf eine andere Platte, einem anderen Rechner oder einem USB-Gerät laden. Ebenfalls ist es ratsam die geretteten Daten auf eine andere Platte zu sichern. das Kommando "dd" ist auf *nix-Systemen sehr hilfreich.

Verbreitete Mythen entzaubert

An dieser Stelle sollen einige verbreitete Irrglauben entzaubert werden:

Open Source Dateisysteme sind weniger anfällig für Datenverlust als proprietäre Systeme: Falsch, NTFS ist minimal besser als ext3, ReiserFs, JFS und XFS, um die verbreitesteten Dateisysteme zu nennen. Einen sehr guten englischen Artikel dazu finden Sie hier.

Journaling-Dateisysteme verhindern korrupte Daten und Datenverlust: Falsch, nur die Geschwindigkeit des Wiederherstellungsprozesses bei einer plötzlichen Unterbrechung während einer Operation ist höher und ein undefinierter Status wird vermieden. Wenn allerdings eine Datei nicht komplett gespeichert wurde bevor das Problem auftrat, ist sie verloren.

RAID-System verhindern korrupte Daten und Datenverlust: Meistens falsch, RAID0 und 1 schützen Sie nicht, RAID5 kann Datenverlust aufgrund von Plattenfehlern, aber nicht aufgrund von Dateisystemfehlern, verhindern. Viele günstige RAID-Controller, und die meisten Controller auf dem Motherboard, melden keine Probleme. Sie werden mögliche Fehler also auch nicht bemerken. Wenn Sie es dann Monate später feststellen, wissen Sie immernoch nicht, dass der Controller die Ursache war. Ein heimtückisches Problem sind defekte Paritätsdaten bei RAID 5. Es ist einfach eine Datei zu lesen und die Metadaten dazu zuzuordnen. Paritätsdaten zu überprüfen ist schwieriger. Sie werden normalerweise Paritätsfehler vor einem Neuaufbau der Partition nicht sehen. Dann ist es natürlich zu spät.

Viren sind die größte Bedrohung für digitale Daten: Falsch, Diebstahl und menschliche Fehler sind die Hauptursachen für Datenverlust.

Machen Sie Ihr Budget: Schätzung des benötigten Speicherplatzes

Sensoren von Digitalkameras sind 1-2 Blendeneinstellungen von fundamentalen physischen Grenzen entfernt. Gemeint ist, dass während sich die Technologie weiter entwickelt, gibt es eine natürliche Grenze für diesen Fortschritt. Empfindlichkeit und Rauschcharakteristiken für alle Arten von Lichtsensoren sind von dieser Grenze nicht mehr weit entfernt.

Heutige Kameras gehen Richtung 10 Megapixelsensoren, auch wenn diese Auflösung schon zu hoch ist für Kompaktkameras und das Endergebnis eher verschlechtert. Eine Sensorgröße von 6 Megapixel und eine qualitativ hochwertigen Optik sind das Optimum für Kompaktkameras. Selbst DSLR Kameras (Spiegelreflexsysteme) haben Ihre Grenze bei 10-12 Megapixel. Für höhere Auflösungen benötigen Sie einen Vollformat-Sensors (24x36mm) oder noch größere Formate.

Wenn Sie den Megapixel Hype der Hersteller mit einbeziehen, dann kann man vermuten, dass die meisten zukünftigen Kameras weniger als 20 Megapixel haben werden. Dadurch erhalten wir eine Abschätzung für den benötigten Speicherplatz pro Foto in der Zukunft: <15 MB pro Bild. Selbst wenn eine Versionierung, also das Gruppieren von Variationen eines Bildes unter der selben Dateireferenz, eingeführt wird, sollte dies ausreichen. Bei der Versionierung geht der Trend zurzeit in Richtung von Skripten, die die Änderungen beschreiben, damit nur eine kleine Datenmenge gespeichert werden muss und nicht das komplette Bild für jede Version. Mit immer schnellerer Hardware wird dieses Konzept sehr schnell reifen.

Um die Menge an Speicherplatz abzuschätzen, den Sie benötigten, müssen Sie nur die Anzahl der Fotos, die Sie pro Jahr machen, mit 15 MB multiplizieren. Die Anzahl der Bilder können Sie leicht mit digiKams Zeitachse ermitteln. Die meisten Benutzer haben weniger als 2000 Bilder pro Jahr und benötigen daher weniger als 30 GB/Jahr. Wenn Sie jetzt davon ausgehen, dass Sie Ihre Festplatte alle 4-5 Jahre erneuern, dann wird das normale Wachstum der Speicherkapazität für Sie ausreichen.

Die Ambitionierteren unter Ihnen werden mehr Platz, unter Umständen sehr viel mehr, benötigen. Sie sollten daher darüber nachdenken, sich einen Dateiserver zu kaufen. Giga-Ethernet ist heutzutage auf den meisten Motherboards integriert und es ist ein Leichtes die Dateien über ein lokales Netzwerk zu erreichen. Moderne Systeme haben einen externen SATA-Stecker, der es ermöglicht, ein entsprechendes externes SATA-Laufwerk anzuschliessen und Ihre Maschine so zu erweitern. 1000 GB Laufwerke werden dieses Jahr (2008) erhältlich werden. Dies sind sagenhafte, kompakte Speichermöglichkeiten für Datensicherungen: Bewahren Sie einfach eine Platte zu Hause und eine Platte auswärts auf.

Sichern, Sichern, Sichern, Wiederherstellen!

Eine 750GB Festplatte bekommen Sie heute für 100 €. Machen Sie also niemanden anderen für Datenverluste verantwortlich. 6% aller PCs sind in jedem Jahr von einem Datenverlust betroffen. Sichern Sie deshalb Ihre Daten häufig nach einem Plan und testen Sie diese Sicherung, bevor Sie irgend etwas Gefährliches wie die Neuinstallation Ihres Betriebssystem, den Austausch von Platten oder der Größenänderung von Partitionen machen.

Katastrophenvorbeugung

Angenommen, Sie machen täglich Ihre Sicherungen auf einem externen SATA-Laufwerk. Wenn dann eines Tages ein Blitz einschlägt, haben Sie Glück, wenn das Laufwerk in dem Augenblick nicht verbunden war.

Ein Unglück schlägt lokal zu und zerstört eine Menge. Vergessen Sie Flugzeugabstürze: Feuer, Wasser, Strom, Kinder und Diebstähle sind für Ihre Daten gefährlich genug. Sie betreffen normalerweise einen ganzen Raum oder das komplette Haus.

Daher bedeutet Katastrophenvorbeugung immer eines auswärtiges Backup. Bringen Sie Ihre Sicherungen in eine andere Etage, in das Nachbarhaus, in Ihr Büro oder ähnliches.

Es gibt einen weiteren Vorteil der physischen Trennung: Wie oben schon gesagt ist ein häufiger Grund für einen Datenverlust trotz Sicherung die Panik. Wenn Sie eine Sicherung haben, die nicht sofort verfügbar ist, dann kann Sie das eines Tages retten, da Sie mehr Zeit zum Überlegen haben.

Sicherungstechniken für Laien erklärt.

Komplette Sicherung: Eine komplette Sicherung aller Dateien, die gesichert werden sollen. Es handelt sich um eine Momentaufnahme ohne Historie und stellt eine komplette Kopie zu einem Zeitpunkt dar.

Differenzsicherung: Eine Sicherung der Dateien, die seit der letzten Komplettsicherung geändert wurden. Erzeugt eine komplette Momentaufnahme zu zwei Zeitpunkten: dem der Komplettsicherung und dem der Differenzsicherung.

Inkrementelle Sicherung: Eine Sicherung der Dateien, die seit der letzten Sicherung geändert wurden. Erzeugt mehrere Momentaufnahmen. Sie können die Komplettsicherung für jeden Sicherungspunkt wieder herstellen. Diese Sicherung kommt einem Versionierungssystem am nächsten mit der Ausnahme, dass es nur punktuell und nicht fortlaufend ist.

Datenintegrität: Besteht, wenn die Daten eindeutig, vollständig und richtig sind.

Bewährtes Verfahren: Tipps für den Computer-Laien

Machen Sie eine Komplettsicherung auf einem externen Gerät.

Überprüfen Sie die Integrität der Daten und legen Sie sie weg (Desastervermeidung).

Besorgen Sie sich ein weiteres Speichergerät für die regelmäßigen Sicherungen.

Tauschen Sie die beiden Geräte jeden Monat aus, nachdem Sie die Integrität der Daten nochmal überprüft haben.

Ein Rezept, mittels rsync Sicherheitskopien zu erstellen.

Rsync ist ein wunderbares kleines Werkzeug, das Sie leicht auf Ihren Maschinen einrichten können. Im Gegensatz zu Skript-gesteuerten FTP Sitzungen oder andere, Arten von Dateiübertragungsskripten, kopiert rsync nur den Unterschied der Dateien, die wirklich geändert wurden. Dies geschieht komprimiert und, wenn Sie möchten, zur Erhöhung der Sicherheit über eine verschlüsselte Verbindung (ssl). rsync kann sogar die Datenintegrität mittels Quersummen überprüfen (Option -c).

Eine machbarer Sicherungsansatz für Bilder könnte wie folgt aussehen:

Sichern Sie wichtige Bilder direkt, nachdem Sie sie auf Ihrem Rechner gespeichert haben auf eine DVD oder ein anderes optisches Medium.

Beginnen Sie mit einer kompletten Sicherung (k).

Machen Sie eine tägliche inkrementelle Sicherung Ihrer Arbeitsdateien (i).

Machen Sie eine wöchentliche Differenzsicherung (d) und löschen Sie die inkrementellen Sicherungen der Woche-2, also von vor zwei Wochen.

Machen Sie eine monatliche Differenzsicherung (d) und löschen Sie die Backups der täglichen und wöchentlichen vom gleichen Tag.

Falls die Backups nicht physisch getrennt sind, dann trennen Sie sie jetzt, in dem Sie die Sicherungslaufwerke austauschen.

Eine grafische Darstellung im Tagesrhythmus könnte folgendermassen aussehen:

k________________________________________________________________________________________

_iiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiiii

___d______d______d______d______d______d______d______d______d______d______d______d______d_

___d___________________________d___________________________d___________________________d_

Ergebnis:

Zum Zeitpunkt jeden Buchstabens auf der Linie können Sie eine vollständige Rücksicherung vornehmen.

k______________________________d___________________________d______d______d______diiiiiidi

Diese Vorgehensweise lässt Ihnen genug Zeit, um Verluste zu entdecken und die Daten wieder herzustellen. Gleichzeitig kommen Sie für die Sicherung aber mit < 130% der Größe der Arbeitsdateien aus. Am Ende haben Sie eine komplette tägliche Version der letzten 7-14 Tage, einer wöchentlichen Momentaufnahme für mindestens einen Monat und eine Momentaufnahme für jeden Monat. Jede weitere Ausdünnung sollte manuell geschehen, nach dem Sie eine komplette Überprüfung gemacht haben.

Ein Skript dem Sie folgen sollten....Muss noch erstellt werden

Deutsch sprechende *nix-Benutzer finden hier eine Anleitung.

Bewahren Sie Ihre Bilder über Besitzerwechsel und Technologiesprünge hinweg

Themen: Metadaten, in der Bilddatei gespeicherte IPTC Informationen, assoziierte XMP-Dateien, Original behalten, Speicher, Skalierbarkeit, Medien, wiederfinden von Bildern und Metadaten, kopieren der Bilder auf die nächste Generation von Medien, Anwendungen, Betriebssysteme, Virtualisierung, Sichtgeräte, Benutzung des Internets usw.

Damit wertvolle Bilder die nächsten 40 Jahr überleben (das ist ungefähr die Zeitspanne in der Sie wirklich an ihnen interessiert sind, weil sie Sie an Ihre Kindheit bzw. Jugend erinnern) gibt es zwei Strategien, die beachtet werden sollten:

Benutzen Sie aktuelle Technologien, und verlieren Sie nicht den Anschluss um mehr als ein paar Jahre.

Speichern Sie Ihre Fotos in einem offenen, nicht-proprietären Standard.

Wie bleiben Sie auf dem aktuellen Stand der Technologie?

Da die Zukunft aufgrund Ihrer Natur unvorhersehbar ist, müssen Sie alles, was heute gesagt wird, mit Vorsicht betrachten und neu bewerten während die Zeit vergeht. Leider gibt es keine andere Möglichkeit, als eine gewisse Wachsamkeit walten zu lassen. Alle 5-8 Jahre sollten Sie sich selber fragen, wie Ihre aktuellen Systeme rückwärts kompatibel sind. Je weniger Varianten Sie in der Vergangenheit benutzt haben, umso leichter ist es, die Fragen der Zukunft zu bewerten.

Natürlich müssen Sie jedesmal, wenn Sie etwas an Ihrem Rechner ändern, Hardware, Betriebssystem, Anwendungen, DRM, sich die gleiche Frage stellen. Wenn Sie heutzutage zu Windows Vista wechseln, dann müssen Sie sich diese Frage dreimal stellen. Können Sie ihre Bilder wieder importieren, und noch wichtiger, können Sie von dort auf ein anderes System wechseln? Die Wahrscheinlichkeit ist hoch, dass Sie dies nicht können. Windows Vista setzt ein strenge DRM- Verwaltung durch, ohne dass Sie einen Einfluss darauf hätten. Wie können Sie also Vista beweisen, dass Sie der Besitzer der Urheberrechte an Ihren Fotos sind?

Diese Frage sollte eigentlich schon anhand der Erklärungen in diesem Dokument beantwortet sein: Benutzen Sie bzw. wechseln Sie zu offenen Standards, die durch viele Anwendungen unterstützt sind.

Betriebssystem-Virtualisierung ist heutzutage für jeden verfügbar. Wenn Sie also ein altes System haben, dass zum Lesen Ihrer Bilder wichtig ist, dann bewahren Sie es auf und installieren Sie es in einer virtuellen Maschine für eine spätere Benutzung.

Auf der anderen Seite ist der Rat recht einfach: Jedesmal wenn Sie Ihre Rechner-Architektur, Ihre Speicher und Sicherungstechnologie, oder Ihr Dateiformat ändern, sollten Sie Ihr Archiv überprüfen, und wenn notwendig zu einem neueren Standard konvertieren. Bleiben Sie bei offenen Standards.

Skalierbarkeit

Skalierbarkeit ist der Fachausdruck für die Möglichkeit, ein System in seiner Größe zu ändern. Dies bedeutet eigentlich immer: Vergrößern.

"EMVS /LVM", zu erledigen

Gehen wir mal davon aus, dass Sie ihr System auf Skalierbarkeit angelegt haben und den Bereich, den Sie vergrößern wollen, auf eine dedizierte Platte oder Partition gelegt haben. Bei *nix Systemen wie Linux können Sie diesen Bereich kopieren und auf eine neue Platte verlagern:

Überprüfen Sie mit dem Kommando dmesg, ob Ihre neue Platte vom System erkannt wurde, aber hängen Sie sie nicht ein.

$ dd if=/dev/sdb[#] of=/dev/sdc # Quelle ist /dev/sdb, die neue Platte ist /dev/sdc

$ parted resize /dev/sdc1 0 <Größe der Platte in MB> # funktioniert mit ext2,3, fat16, 32 und reiserfs

$ resize2fs /dev/sadc1 # ändern der Größe von reiserfs falls nötig

TBC

Benutzen Sie offene, nicht-proprietäre Standards als Dateiformat

Die kurze Geschichte des digitalen Zeitalters in den letzten 30 Jahren hat immer wieder gezeigt, dass proprietäre Formate nicht geeignet sind, wenn Sie Ihre Daten 10 Jahre oder länger benutzen wollen. Microsoft ist sicherlich einer der bekannteren Täter, da es den Markt dominiert. Aber andere Firmen sind vielleicht noch schlimmer, da Sie unter Umständen nicht lang genug am Markt sind oder nur eine geringe Benutzerzahl haben. Im Falle von Microsoft haben Sie zumindest den Vorteil, dass Sie Ihr Problem mit vielen Menschen teilen. Daher ist hier die Suche nach Lösungen häufiger erfolgreich. Normalerweise können Sie mit einer MS Office Version Dokumente lesen, die zwei Versionen früher erstellt wurden.

Bildformate haben eine längere Lebenszeit, als MSOffice-Dokumente und veralten weniger schnell.

Open Source Standards haben den großen Vorteil einer offenen Spezifikation. Selbst wenn es eines Tages keine Software mehr gibt, die es lesen kann, dann können Sie diese selbst erstellen. Diese Aufgabe wird von Jahr zu Jahr einfacher. Sie können sogar, um ein konkretes Beispiel anzuführen, Ihre RAW Bilddateien-Kompatibilität schützen, indem Sie eine Kopie von dcraw im Quelltext, welche weniger als 300KB gross ist, mit in Ihr Archiv packen. So haben Sie später immer noch das probate Werkzeug zum Entpacken zur Verfügung.

JPEG existiert schon eine längere Zeit und, obwohl kein verlustfreies Format bei dem Sie bei jeder Änderung, die Sie speichern, ein wenig Qualität verlieren, ist es allgegenwärtig. Es unterstützt JFIF-, Exif-, IPTC- und XMP-Metadaten, verfügt über gute Kompressionswerte und kann von jeder Bildbearbeitungssoftware gelesen werden. Wegen der Limitierung seiner Metadaten, der verlustbehafteten Speicherung, der fehlenden Unterstützung für Transparenz und der Farbtiefe von 8 Bit können wir es nicht empfehlen. JPEG2000 ist besser und kann verlustfrei arbeiten, hat aber eine kleine Benutzerbasis.

GIF ist ein proprietäres, patentiertes Format, das langsam vom Markt verschwindet. Sie sollten es daher nicht mehr benutzen.

PNG wurde als ein OpenSource Standard entwickelt, der GIF ersetzen sollte. Es kann aber viel mehr. Es ist verlustfrei, unterstützt XMP, Exif und IPTC Metadaten, 16-Bit pro Farbkanal und kennt volle Transparenz. PNG kann Gamma- und Farbprofile für eine verbesserte Farbzuweisung bei heterogenen Plattformen speichern. Der Nachteil ist, dass es relative viele Verwaltungsinformationen (jedoch weniger als TIFF) benötigt und eine langsame Kommpression besitzt. Dieses Format kann ich Ihnen zum Speichern Ihrer Bilder empfehlen.

TIFF war weit verbreitet als Bildformat. TIFF kann in unkomprimierter Form oder in einem Container mit einer verlustfreien Kompressionsalgorithmus (Deflate) gespeichert werden. Es verwaltet Bilder in hoher Qualität, benötigt aber sehr große Dateien. Bei einigen Kameras können Sie Ihre Bilder in diesem Format abspeichern. Ein Problem ist allerdings, dass dieses Format von vielen Leuten angepasst wurde. Es gibt daher mehr als 50 verschiedene Varianten, und nicht alle Anwendungen können mit allen Varianten arbeiten.

RAW-format (Rohformat). Einige, typischerweise sehr teure Kameras, unterstützen Aufnahmen im Rohformat. Das Rohformat ist eigentlich kein Bildstandard, sondern ein Containerformat, das für jede Marke und Kamera verschieden ist. Rohformatbilder enthalten nur minimal bearbeitete Daten direkt aus dem Bildsensor der Digitalkamera oder des Bildscanners. Rohbilddateien werden daher manchmal auch digitale Negative genannt, da sie die gleiche Rolle erfüllen wie Filmnegative in der traditionellen chemischen Fotografie: d.h. dass das Negativ selbst nicht direkt nutzbar ist als Bild, aber alle Informationen enthält, um ein Bild zu erstellen. Fotos im Rohformat einer Kamera zu speichern, stellt einen höheren dynamischen Bereich als das übliche JPEG Format zur Verfügung und erlaubt es Ihnen, Einstellungen wie Weißabgleich nach dem das Foto gemacht wurde zu ändern. Die meisten professionellen Fotografen benutzen das Rohformat, da es Ihnen die größtmögliche Flexibilität bietet. Der Nachteil ist, dass Rohbilddateien sehr groß sein können.

Es ist eine gute Idee, die Bilder im Rohformat aufzunehmen, aber Sie sollten darauf verzichten, Bilder im Rohformat zu archivieren. Es besitzt alle schlechten Eigenschaften: Es gibt viele Variationen und es ist proprietär. Ebenfalls ist es klar, dass Sie mit Ihren alten Rohdateien in ein paar Jahren nichts mehr anfangen können (es sei denn, Sie haben dcraw dazugepackt). Wenn Sie Ihre Kamera wechseln, können Sie Ihre Farbprofile verlieren, und es ist dann sehr schwierig, die alten Rohdateien richtig wieder zu geben. Wechseln Sie daher besser auf das DNG-Format.

DNG Das Digitale Negative Dateiformat ist ein lizenzfreies und offenes Rohbildformat, dass von Adobe Systems entwickelt wurde. DNG entstand aufgrund des Bedürfnisses, die Kamerarohformate zu vereinheitlichen (ein Ziel, woran die OpenRAW-Initiative bislang gescheitert ist). Es basiert auf dem TIFF/EP Format und verpflichtet zur Benutzung von Metadaten. Eine handvoll Kamerahersteller stellt DNG schon jetzt zur Verfügung und ich hoffe, dass die Hauptakteure Canon und Nikon es auch irgendwann benutzen. -> Alles was Sie schon immer über DNG wissen wollten.

Wir empfehlen Ihnen daher Ihre Rohdateien zur Archivierung nach DNG zu konvertieren. Abgesehen von dem Fakt, dass DNG von Adobe erstellt wurde, ist es ein offener Standard und durch die OpenSource Gemeinschaft akzeptiert. Dies sind normaler Weise gute Indikatoren für eine lange Haltbarkeit. Einige Hersteller haben DNG schon als Rohformat eingeführt, und nicht zuletzt ist Adobe heutzutage ein sehr wichtiger Anbieter für grafische Software. Sie werden natürlich auch Ihre eigene Erfindung unterstützen. Es ist ein ideales Format zur Archivierung der Daten des Rohsensors, und diese werden entweder im linearen TIFF-Format, als 'embedded RAW' oder als undekodierte Rohdaten plus Farbprofil im DNG Container konserviert. Das Risiko, das mit dem proprietären Rohformat verbunden ist, wird so gemildert. All dieses macht den Wechsel zu einem anderen Betriebssystem zu einer Leichtigkeit. In naher Zukunft werden Sie eine "nicht-zerstörende Bearbeitung" haben, bei der die Bilddateien nicht mehr geändert werden. Stattdessen werden alle Bearbeitungsschritte aufgezeichnet und als Skript innerhalb des DNG gespeichert. Wenn Sie eine solche Datei wieder öffnen, dann wird das Bearbeitungsskript abgespielt. Dies fordert eine hohe Rechnergeschwindigkeit, lässt aber das Original intakt.

XML (Extensible Mark-up Language) oder RDF (Resource Description Framework). XML ist ähnlich wie HTML, aber während HTML sich hauptsächlich um die Darstellung der Daten konzentriert, liegt der Schwerpunkt bei XML bei der "Repräsentation" der Daten, ist also Metadaten-geeignet. Zusätzlich ist XML nicht-proprietär, unabhängig vom Betriebssystem, einfach zu interpretieren, Text-basierend und kostengünstig. RDF ist die Lösung vom WC3 Konsortium, um eine Anzahl unterschiedlicher Anwendungen wie Bibliothekskataloge, weltweite Verzeichnisse, Nachrichten-Feeds, Software, Musiksammlungen, Bilder und Ereignisse mittels XML als Austauschsprache zu integrieren. Beide Spezifikationen zusammen stellen eine Methode zur Verfügung, um eine leichtgewichtige Ontologie basierend auf dem Dublin Core zu benutzen. Das Dublin Core unterstützt auch das "semantische Web" und somit den leichten Austausch von Wissen über das Internet.

IPTC wird zu XMP

Dies ist möglicherweise einer der Gründe, warum Adobe um 2001 seine XML basierende XMP-Technologie eingeführt hat, um die "Bildressourcenblock"-Technologie der 90er Jahre zu ersetzen. XMP steht für "Extensible Metadata Platform", eine Mischung von XML und RDF. Es handelt sich um eine Kennzeichnungstechnologie, die es Benutzern erlaubt, ihre Daten in eine Datei selbst einzubetten. Die Dateiinformationen werden mit der Erweiterung ".xmp" gespeichert, die für XML/RDF steht.

XMP: Wie das Oasis Format ODF wird es für immer lesbar sein, da der enthaltene Text in Klartext enthalten ist, XMP speichert Ihre Metadaten in dem gut zu verstehenden Format XML. Es gibt also keine Gefahr, dass Sie dies später nicht mehr lesen könnten. Es kann in eine Bilddatei eingebettet werden oder als eine separate zugehörige Datei gespeichert werden. XMP kann in PDF, JPEG, JPEG2000, GIF, PNG, HTML, TIFF, Adobe Illustrator, PSD, PostScript und Encapsulated PostScript benutzt werden. In einer bearbeiteten JPEG-Datei sind die XMP-Informationen typischerweise zusätzlich zu den Exif und IPTC Daten enthalten.

In Dateien eingebettete Metadaten erlauben es, einfach die Dateien zu teilen und sie über Produkte, Händler, Plattformen und Kunden weiter zu transferieren, ohne dass die Metadaten verloren gehen. Die verbreitetsten Metadaten, die in XMP gespeichert werden, sind die aus der Dublin Core Metadateninitiative. Sie enthalten unter anderem Titel, Beschreibung, Ersteller usw. Der Standard ist erweiterbar und erlaubt es den Benutzern, Ihre eigenen Arten von Metadaten in den XMP-Daten zu speichern. XMP erlaubt es generell, nicht binäre Datentypen einzubetten. Daher müssen alle binäre Daten, wie Vorschaubilder, die in XMP gespeichert werden, in ein XML-freundliches Format, wie z.B. Base64, konvertiert werden.

Viele Fotografen ziehen es vor, ein Original Ihrer Aufnahme, meistens im Rohformat, zu archivieren. XMP passt dazu, da es die Metadaten separat von der Bilddatei speichert. Es kann aber zu Problemen bei der Verknüpfung zwischen der Metadatendatei und der Bilddatei kommen, und wie oben schon angemerkt, werden viele Rohformate veralten. Daher sollten Sie überlegen, ob Sie DNG als Container benutzen und alles dort zusammen legen.

The Dublin Core Metadata Initiative ist eine offene Organisation, die sich für vollständig kompatible Online-Metadatenstandards einsetzt, die einen großen Bereich von Einsatzzwecken und Geschäftsmodelle unterstützen. Zu den Aktivitäten von DCMI gehört die Arbeit an einer Architektur und Modellierung, Diskussionen und gemeinschaftliche Arbeit in den DCMI-Communities und den DCMI-Arbeitsgruppen, jährliche Konferenzen und Workshops, Standardverbindungen und Aufklärungsarbeit, um eine weitgehende Akzeptanz von Metadatenstandards und Praktiken zu erreichen.

Zusammenfassung

Bewährtes Verfahren: Datensicherung

Benutzen Sie einen Überspannungschutz gemäß UL 1449 Standard, am Besten kombiniert mit einer USV.

Benutzen Sie ECC-Speicher, um sicher zu stellen, dass Sie die richtigen Daten beim Speichern von Dateien, übertragen haben.

Beobachten Sie Ihre Festplatten (Temperatur, Geräusche ...) und machen Sie Sicherungen.

Bewahren Sie die Sicherungen an einem anderen, abgeschlossenen Ort auf. Benutzen Sie Web-Speicherplatz.

Benutzen Sie Archivierungsmedien und -brenner.

Bekommen Sie keine Panik bei Datenverlust, und erklären Sie Ihren Rettungsplan einem Laien bevor Sie zur Tat schreiten.

Wählen Sie ihr Dateisystem, Ihre Partitionen und Ordner in Hinblick auf eine einfache Skalierbarkeit.

Benutzen Sie offene, nicht-proprietäre Standards, um Ihre Fotos zu speichern und zu verwalten.

Führen Sie Technologie-/Migrationsbewertung spätestens alle fünf Jahre durch.

Ein typischer Arbeitsablauf (workflow) der digitalen Bestandsverwaltung mit digiKam.

Importieren Sie Bilder von der Kamera, dem Kartenleser oder dem Scanner. So lange die Bilder auf dem Kameramedium sind, können Sie dies als temporäre Sicherung benutzen.

Konvertieren Sie Rohdateien nach DNG und speichern Sie diese in Ihrem Roharchiv. (Diese Funktion ist noch nicht implementiert, Stand 03/08.)

Bewerten und wählen Sie aus. Schreiben Sie diese Metadaten in Ihr DNG-Archiv.

Erstellen Sie eine Sicherung z.B. auf DVD, einem optischen oder einem Bandlaufwerk.

Fügen Sie Stichwörter, Kommentare und die geographische Lokalisierung hinzu.

Bearbeiten und verbessern Sie Ihre Fotos.

Für eine Bearbeitung, die mehrere Ebenen erfordert, können Sie externe Programme benutzen. Wenn Sie die Bilder wieder mit digiKam bearbeiten, dann sollten Sie die Metadaten wieder hinzufügen. Diese wurden unter Umständen von den anderen Programmen abgeschnitten.

Benutzen Sie eine Sicherungsroutine und überprüfen Sie im Anschluss die Datenintegrität.

Schützen Sie das Urheberrecht der bearbeiteten Bilder mit einem digitalen Wasserzeichen. Exportieren Sie sie erst danach in Webgalerien, MPEG-Enkoder, Kontaktabzüge, Druck usw.

Arbeitsablauf